在现代社交网络中,QQ空间作为一个重要的信息交流平台,吸引了大量用户的关注。然而,如何在本地监控环境下实现QQ空间的无限刷新,成为了许多技术爱好者探讨的课题。本文将深入探讨这一话题,分析其可行性,并提供相关技术实现的思路。

首先,我们需要明确本地监控的概念。本地监控通常指的是在用户本地设备上进行的监控操作,这可以是软件层面的监控,也可以是硬件层面的监控。对于QQ空间而言,本地监控主要涉及到对网络请求的捕获和分析。

QQ空间无限刷新的实现,核心在于模拟正常的用户行为,绕过平台的反爬虫机制。这涉及到多个技术层面的问题,包括但不限于网络请求的模拟、数据解析、以及反爬虫策略的应对。

技术实现步骤

-

网络请求分析:

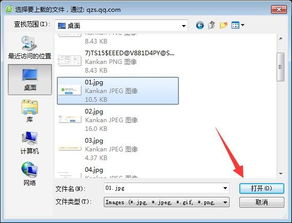

要实现QQ空间的无限刷新,首先需要对QQ空间的网络请求进行深入分析。通过抓包工具(如Wireshark、Fiddler等),可以捕获到QQ空间加载新内容的网络请求。这些请求通常包含特定的参数,如时间戳、用户ID等。 -

模拟网络请求:

在分析清楚网络请求的构成后,下一步是模拟这些请求。可以使用Python等编程语言,结合requests库,构造相应的HTTP请求。关键在于精确模拟请求头和请求参数,以确保服务器识别为正常用户行为。import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

'Cookie': 'your_cookie_here'

}

params = {

'timestamp': '1625234567',

'userID': 'your_userID_here'

}

response = requests.get('https://qzone.qq.com/cgi-bin/get_feeds', headers=headers, params=params)

print(response.text)

-

数据解析:

服务器返回的数据通常是JSON格式,需要对这些数据进行解析,提取出有用的信息。可以使用Python的json库进行解析。import json

data = json.loads(response.text)

feeds = data['feeds']

for feed in feeds:

print(feed['content'])

-

反爬虫策略应对:

QQ空间为了防止恶意爬虫,通常会采取一系列反爬虫措施,如IP封禁、验证码等。应对这些措施,可以采用代理IP池、模拟用户行为等方法。- 代理IP池:通过使用代理IP,可以有效避免单一IP被封禁的问题。

- 模拟用户行为:在请求间隔、请求频率等方面,尽量模拟正常用户的行为模式。

可行性分析

从技术角度来看,实现QQ空间的无限刷新是理论上可行的。然而,实际操作中面临诸多挑战:

- 法律风险:未经授权的爬虫行为可能违反相关法律法规,存在法律风险。

- 技术难度:QQ空间的反爬虫机制不断升级,技术实现难度较大。

- 数据价值:即使成功实现无限刷新,获取的数据是否有实际价值,仍需进一步评估。

注意事项

- 遵守法律法规:在进行任何爬虫操作前,务必确保行为合法,避免触犯法律。

- 尊重用户隐私:获取的数据应严格保密,不得用于非法用途。

- 技术更新:QQ空间的反爬虫机制不断更新,需持续关注技术动态,及时调整策略。

总结

通过上述分析,我们可以看出,实现本地监控下的QQ空间无限刷新在技术上是可行的,但面临诸多挑战和风险。建议在进行相关操作时,务必遵守法律法规,尊重用户隐私,确保行为的合法性和正当性。

在实际应用中,还需根据具体情况,灵活调整技术策略,以应对不断变化的网络环境。希望本文的探讨,能为有兴趣的技术爱好者提供一些有益的参考。